智源研究院在2023年7月13日宣布了一个重大突破,其「悟道·视界」研究团队成功开发并开源了Emu模型——首个实现从多模态输入到多模态输出的「全能高手」。这一模型不仅在性能上超越了DeepMind的Flamingo,刷新了8项性能指标,还在图像与文本生成及视频理解等多个领域展现了其通用性和强大的多模态任务处理能力。

工具简介和背景

Emu模型是一个基于Transformer的多模态基础模型,它通过创造性地建立多模态统一学习框架,并大量采用视频数据,实现了对任意形式的多模态上下文序列进行图文任意模态的补全。这一创新使得Emu在多模态任务中表现出色,无论是图像到文本的转换还是文本到图像的生成,Emu都能游刃有余。

主要功能和产品特色

- 性能卓越:Emu在8个多模态图像/视频和语言任务的基准测试中表现优异,超越了Flamingo和Kosmos。

- 零样本性能:展现出在未知任务上的泛化能力,尤其在图像描述和视频问答任务中。

- 少样本上下文学习:Emu能够基于给定任务的几个示例样本进行上下文学习,有效提升任务完成度。

- 全能生成能力:Emu模型不仅能够生成图像和文本,还能理解视频内容,实现任意图生文及文生图的多模态任务。

需求人群

Emu模型适用于需要处理多模态数据的研究人员和开发者,特别是在视觉、语言应用和多模态学习领域。

变现技巧

Emu模型的开源特性为开发者提供了广泛的应用场景,包括但不限于图像和视频内容的自动标注、多模态数据的分析与理解、以及基于上下文的图像和文本生成等。

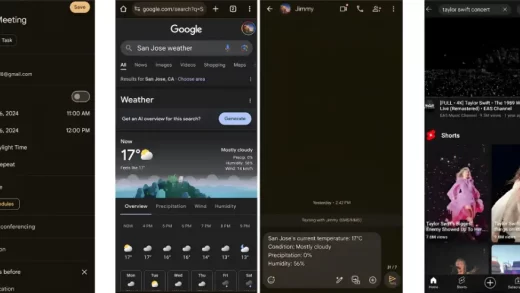

使用场景示例

- 图像和文本生成:Emu可以根据给定的文本生成语义相关的图像,或根据图像生成详细的描述。

- 视频理解:Emu能够理解视频中的内容,并提供精准的事实细节和连贯的动作描述。

- 多模态对话:基于Emu的多模态对话能力,可以实现更加自然和丰富的人机交互体验。

费用定价

Emu模型作为开源项目,用户可以免费使用其代码和模型,促进了多模态领域的研究和应用开发。

论文链接:Emu: Generative Pretraining in Multimodality

模型链接:GitHub – baaivision/Emu

Demo链接:Emu Demo

智源研究院的这一开源项目不仅推动了多模态技术的发展,也为AI社区提供了宝贵的资源,进一步促进了人工智能领域的创新和合作。