M2UGen,一个前沿的多模态音乐理解和生成模型项目,正在通过结合多种先进的语言和图像模型,推动音乐创作和理解的边界。本文将深入介绍M2UGen的背景、主要功能、产品特色、目标用户群体、使用场景,以及如何体验这一创新技术。

工具简介和背景

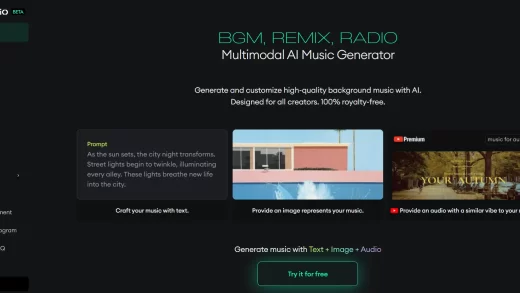

在AI技术的不断进步下,音乐创作领域也迎来了革命性的变化。M2UGen项目利用大型语言模型,结合MU-LLaMA、MosaicML的MPT-7B-Chat、BLIP图像字幕模型和VideoMAE字幕模型,生成音乐相关的数据集,并实现音乐的生成与理解。

主要功能和产品特色

- 文本到音乐生成:根据给定文本内容,生成相应的音乐作品。

- 图像到音乐生成:将视觉艺术转换为音乐表达,根据图像生成音乐。

- 视频到音乐生成:分析视频内容,生成与视频情感和场景相匹配的音乐。

- 音乐编辑:提供音乐编辑功能,对已有音乐作品进行创意性修改。

需求人群

M2UGen适合以下用户群体:

- 音乐制作人:寻找新的音乐创作灵感和工具。

- 独立艺术家:希望快速将创意转化为音乐作品。

- 音乐爱好者:对AI音乐创作感兴趣的个人。

- 技术开发者:探索AI在音乐领域的应用。

使用场景示例

- 音乐创作:根据文本描述生成电影配乐或广告背景音乐。

- 艺术融合:将图像或视频的艺术元素转化为音乐,创造跨媒体艺术作品。

- 音乐教育:作为教学工具,帮助学生理解音乐与视觉艺术的关联。

- 娱乐体验:为社交媒体和游戏平台提供个性化音乐内容。

demo体验

用户可以通过以下地址体验M2UGen的demo: