CogAgent 是由清华大学与智谱AI联合开发的一款先进的视觉语言模型(VLM),专为图形用户界面(GUI)的理解和导航而设计。该模型结合了低分辨率和高分辨率图像编码器,能够处理高达1120×1120分辨率的图像,识别和理解复杂的GUI元素和文本内容。

主要功能与产品特色

- 高分辨率图像理解:CogAgent-18B支持110亿视觉参数和70亿语言参数,能够识别和解释小型GUI元素和文本。

- 卓越的跨模态性能:在多个跨模态基准测试中取得最先进的性能,包括VQAv2、OK-VQA等。

- GUI操作优势:在AITW和Mind2Web等GUI操作数据集上显著超越现有模型,提升GUI交互的效率和准确性。

需求人群

CogAgent适用于以下需求人群:

变现技巧

企业和开发者可以通过将CogAgent集成到自己的软件产品和服务中,提供自动化GUI操作、用户交互优化等增值服务,从而创造商业价值。

使用场景示例

- 自动化软件测试:利用CogAgent自动化执行软件测试中的GUI操作。

- 智能助手开发:集成CogAgent到智能助手中,提供用户界面操作指导和帮助。

- 无障碍技术支持:为视觉障碍人士提供GUI元素识别和操作辅助。

费用定价

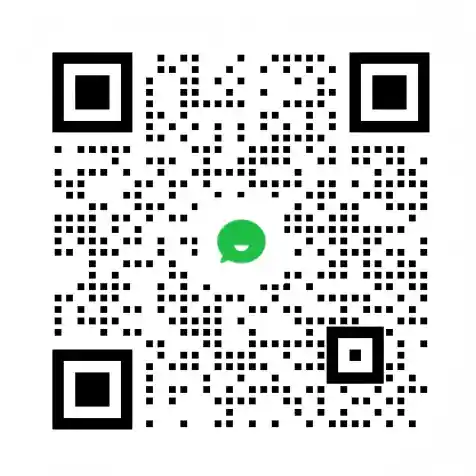

CogAgent的代码和论文已开源,可免费商用。在线体验功能通过Streamlit(http://36.103.203.44:7861/)提供。具体的使用和许可条件,请参考相关开源协议。

如何使用CogAgent?

CogAgent对外开放了论文、代码,提供了在线体验功能: