DeepSeek-V2,由杭州深度求索公司精心打造的第二代开源MoE(Mixture of Experts)模型,以其卓越的性能和广泛的应用前景,正逐渐在人工智能领域崭露头角。在与GPT-4-Turbo、文心4.0等闭源模型的较量中,DeepSeek-V2展现出了不凡的中文综合能力。同时,在英文综合能力(MT-Bench)方面,它与开源模型LLaMA3-70B并肩,超越了MoE开源模型Mixtral8x22B,尤其在数学、编程和逻辑推理任务上表现突出。

主要功能和产品特色

- 综合能力:DeepSeek-V2在多个大型模型排行榜上名列前茅,支持长达128K的上下文长度,聊天和API支持32K上下文长度,为处理复杂任务提供了强有力的支持。

- 数学、编程和推理专长:在技术领域和需要复杂决策的应用中,DeepSeek-V2的这些专长使其成为不二之选。

- 大规模参数:拥有236B参数,DeepSeek-V2是一个大型、复杂的模型,能够处理和学习大量的数据。

- 与OpenAI API兼容:DeepSeek-V2的兼容性意味着它可以无缝集成到现有的使用OpenAI服务的系统中。

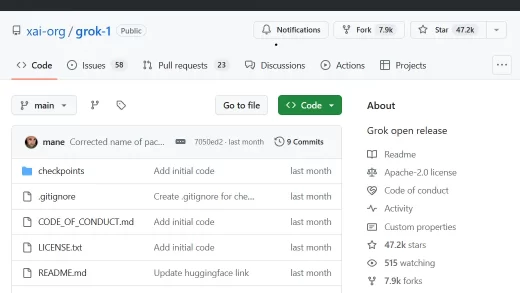

- 开源特性:开放源代码,让开发者和研究人员可以访问其底层代码,进行自定义和进一步的研究。

需求人群、变现技巧

DeepSeek-V2适用于需要处理复杂数学问题、编程任务和逻辑推理的应用场景,对于企业和技术开发者而言,它不仅性能卓越,而且定价合理,是一个经济实惠且实用的选择。

使用场景示例

无论是在教育领域的智能辅导,还是在软件开发中的代码生成,亦或是在企业决策中的数据分析,DeepSeek-V2都能以其强大的能力提供支持。

费用定价

DeepSeek-V2的API定价如下:

- 每百万输入Tokens:1元(0.14美元)

- 每百万输出Tokens:2元(0.28美元)

外链增补

- 官网体验:DeepSeek-V2官网

- 技术报告:DeepSeek-V2技术报告

- GitHub项目:DeepSeek-LLM GitHub